Da anni ormai, la Ricerca Google è molto testuale, con utilità come la ricerca inversa di immagini e, più recentemente, Google Lens, che aggiungono un certo grado di comodità attraverso le ricerche visive. Sebbene la società abbia annunciato il supporto per le query video nella Ricerca durante il keynote della conferenza annuale degli sviluppatori, Gemini AI ha consentito un modo completamente nuovo di cercare informazioni utilizzando l’intelligenza artificiale quasi in tempo reale con Gemini Live e Project Astra.

Gemini Live

Per quanto riguarda Gemini Live, è una nuova esperienza mobile per conversazioni naturali con la sua intelligenza artificiale.

Google ha offerto alcuni potenziali casi d’uso: potresti avere una conversazione con Gemini Live per aiutarti a prepararti per un colloquio di lavoro, dove potrebbe potenzialmente farti domande pertinenti sulle posizioni. Potrebbe anche darti consigli per parlare in pubblico se desideri fare ricerche su un discorso.

Ciò che rende Gemini Live unico è che potrai parlare al tuo ritmo o anche interrompere le sue risposte, se lo desideri. Idealmente, dovrebbe essere più come avere una conversazione con una persona, invece di limitarsi a pronunciare comandi di assistente intelligente o query di intelligenza artificiale generativa.

Project Astra

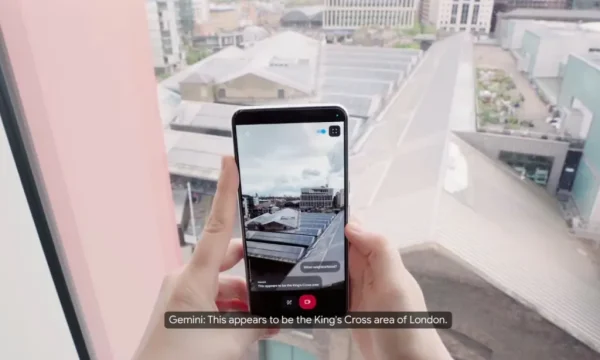

Durante la presentazione keynote di Google I/O, il fondatore di Google DeepMind, Demis Hassabis, ha parlato delle sfide tecniche dell’elaborazione multimodale degli input per le interazioni AI in Gemini. Portando il concetto di Gemini Live un passo avanti, la presentazione di Project Astra è poi stata divisa in due clip consecutive, la prima con suggerimenti audiovisivi in tempo reale mentre il presentatore chiede all’app Gemini sul proprio telefono di identificare oggetti, creare rime poetiche, riassumere il codice sullo schermo e identificare una posizione in base alla vista fuori da una finestra come un giocatore GeoGuessr.

Tuttavia, la parte più interessante è stata il segmento più breve che è seguito, in cui il presentatore ha indossato un paio di smart glass con fotocamere e accesso a Gemini AI per rendere l’esperienza dell’app mobile più, beh… mobile.

Il Project Astra di Google, anticipato nelle ore precedenti al Google I/O da un teaser dell’azienda, è la migliore risposta che il colosso ha a disposizione al lancio di GPT-4o di OpenAI che ha stupito tutti.

Project Astra è il Google Glass che meritiamo

Nome in codice Project Astra, questi occhiali assomigliano ai tipici occhiali intelligenti con un design grosso che ricorda i Bose Frames, ma con funzionalità che ricordano gli occhiali intelligenti di Meta in collaborazione con Ray-Ban. Usando gli occhiali, il presentatore poteva indirizzare l’attenzione dell’intelligenza artificiale su ciò che stava guardando in modo più intuitivo, senza gestire un dispositivo secondario.

Nel primo esempio, Gemini su Astra ha ottimizzato un diagramma di flusso del server aggiungendo una cache, poi ha capito un riferimento disegnato a mano al paradosso del gatto di Schrödinger e infine ha scelto un nome divertente per una band composta da un golden retriever e la sua tigre giocattolo.

Per quello che vale, Google afferma che il video non è stato accelerato ed è stato registrato in un’unica ripresa. Anche se fosse accelerato, è sorprendente quanto gli occhiali possano fare con fotocamere, altoparlanti e gli ultimi progressi tecnologici di Google. Un altro elemento notevole è l’immediatezza della risposta dell’intelligenza artificiale, che ci porterebbe a credere che gli occhiali siano abbinati a un hardware più potente come un telefono perché il networking e l’elaborazione integrata sugli occhiali aggiungerebbero notevole volume al design.

Sebbene l’azienda non si sia impegnata a rispettare le scadenze per un potenziale lancio del Project Astra come prodotto tangibile, siamo lieti che l’azienda non abbia abbandonato i computer indossabili da quando Google Glass non è riuscito a decollare.