In una guida precedente vi ho mostrato come installare Ollama e i vari modelli open source per eseguire gli LLM in locale su Windows, macOS e Linux. Tuttavia, Ollama così com’è non è il massimo, in quanto l’uso avviene attraverso la riga di comando del terminale. In questa guida voglio mostrarvi come utilizzare invece OpenWebUI per avere un’interfaccia grafica semplice, pulita e ispirata a ChatGPT.

OpenWebUI (precedentemente Ollama WebUI) è un server Web open source per Ollama con una UI ispirata da ChatGPT. Si ispira all’interfaccia utente web OpenAI ChatGPT, molto intuitiva e ricca di funzionalità. Soprattutto, funziona benissimo con Ollama.

Le caratteristiche di OpenWebUI

L’utilizzo di OpenWebUI per utilizzare Ollama e quindi tutte le IA generative open source disponibili va oltre la semplice interfaccia grafica. Gli sviluppatori hanno speso molto tempo per implementare al meglio una serie di funzioni che pongono questo software in pari con le controparti a pagamento più blasonati.

- Interfaccia intuitiva: l’interfaccia di chat si ispira a ChatGPT, garantendo un’esperienza user-friendly.

- Design responsive: goditi un’esperienza fluida sia su desktop che su dispositivi mobili.

- Reattività rapida: goditi prestazioni veloci e reattive

- Personalizzazione del tema: scegli tra una varietà di temi per personalizzare la tua esperienza Open WebUI.

- Evidenziazione della sintassi del codice: goditi una migliore leggibilità del codice con la funzione di evidenziazione della sintassi.

- Supporto completo Markdown e LaTeX: migliora la tua esperienza LLM con funzionalità complete Markdown e LaTeX per un’interazione arricchita

- Supporto dei prompt preimpostati: accedi istantaneamente ai prompt preimpostati utilizzando il comando / nell’input della chat. Carica facilmente i prompt di conversazione predefiniti e accelera le tue interazioni. Importa facilmente i prompt tramite l’integrazione della community Open WebUI.

- Scarica/Elimina modelli: scarica o rimuovi facilmente i modelli direttamente dall’interfaccia utente web.

- Aggiorna tutti i modelli Ollama: aggiorna facilmente i modelli installati localmente tutti in una volta con un comodo pulsante, semplificando la gestione dei modelli

- Cronologia chat: accedi e gestisci facilmente la cronologia delle conversazioni.

- Archivia chat: archivia facilmente le conversazioni completate con LLM per riferimento futuro, mantenendo un’interfaccia di chat ordinata e priva di ingombri e consentendo al contempo un facile recupero e consultazione.

- Importa/Esporta cronologia chat: sposta senza problemi i dati della chat dentro e fuori la piattaforma.

- Supporto per input vocale: interagisci con il tuo modello attraverso interazioni vocali; goditi la comodità di parlare direttamente con il tuo modello. Inoltre, esplora l’opzione per inviare automaticamente l’input vocale dopo 3 secondi di silenzio per un’esperienza semplificata.

Come installare OpenWebUI

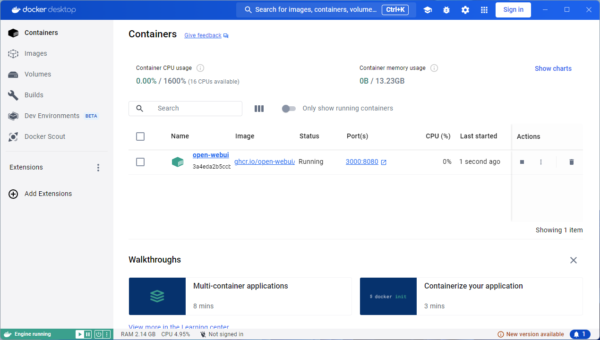

Il modo più semplice per installare OpenWebUI è con Docker. Per utilizzare questo metodo, è necessario un motore Docker, come Docker Desktop o Rancher Desktop in esecuzione sul tuo computer locale. Basta semplicemente scaricare il file ed eseguire una normale installazione.

Con questo in atto, installare OpenWebUI è semplice come inserire il seguente comando:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Se avete sul vostro computer una GPU Nvidia, dovete invece utilizzare quest’altro comando:

docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda

Dopo di che, tutto è pronto per eseguire OpenWebUI su un qualsiasi browser web (sia desktop che mobile).

Come utilizzare OpenWebUI con Ollama

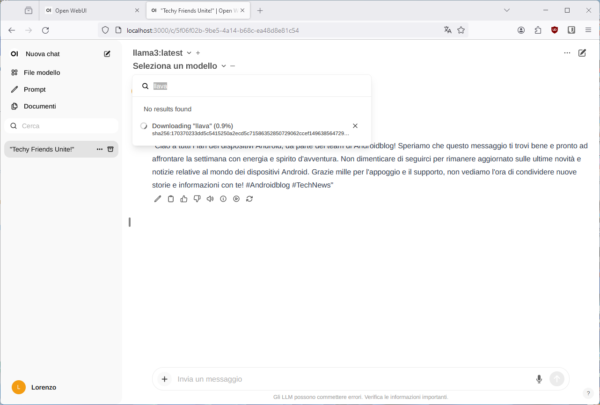

Una volta configurato, con Ollama in esecuzione puoi accedere a http://localhost:3000/, registrare un account locale (puoi anche inventare la mail e la password, dal momento che il funzionamento è totalmente offline) e iniziare a chattare.

L’interfaccia grafica assomiglia molto a quella di ChatGPT, che a sua volta assomiglia molto a quella delle app di messaggistica. Basta infatti selezionare un LLM precedentemente scaricato dal menu in alto, iniziare a digitare i prompt nella casella in basso e attendere la risposta dell’LLM selezionato.

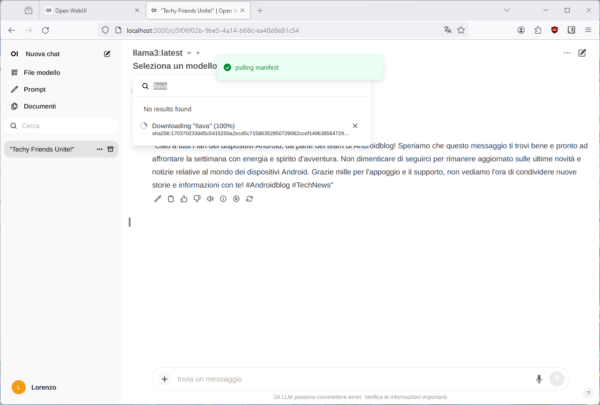

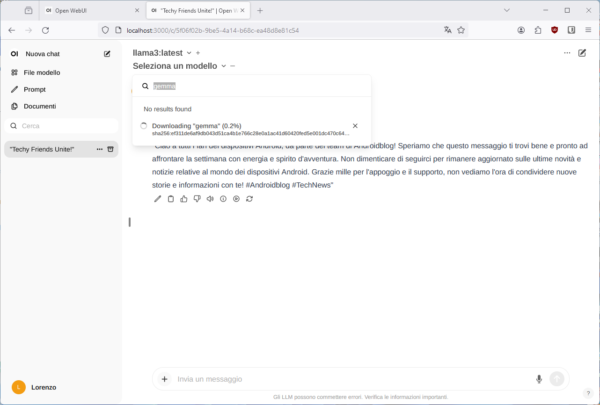

Nel caso in cui non aveste scaricato un modello LLM in precedenza, è possibile procedere al download utilizzando direttamente questa nuova UI semplificata. Invece di digitare ollama run "nomemodello" dal terminale, puoi semplicemente digitare nella casella di ricerca in alto il nome del modello e premere Invio sulla tastiera. Il modello verrà scaricato in background.

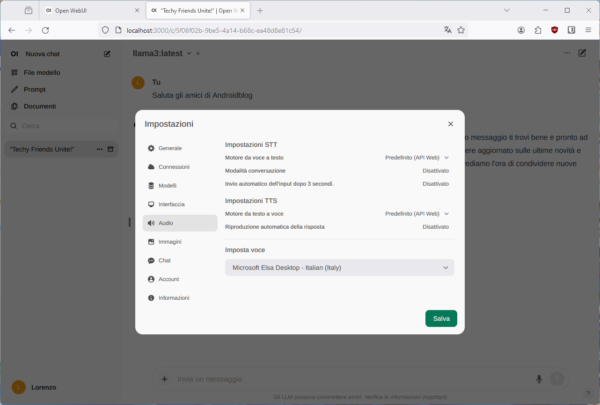

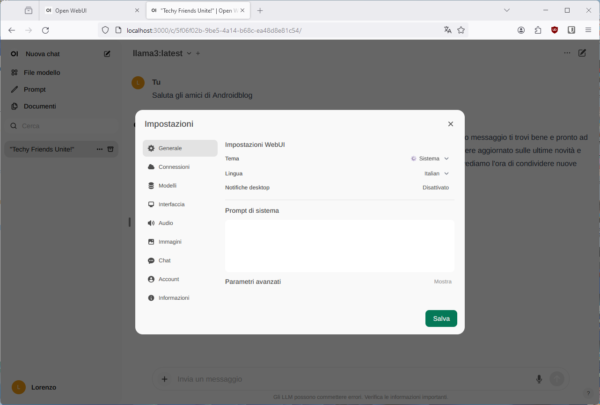

Dalle impostazioni è possibile modificare alcuni parametri, come ad esempio la lingua dell’interfaccia grafica e il modello di sintesi vocale da usare per leggere le risposte del chatbot AI.