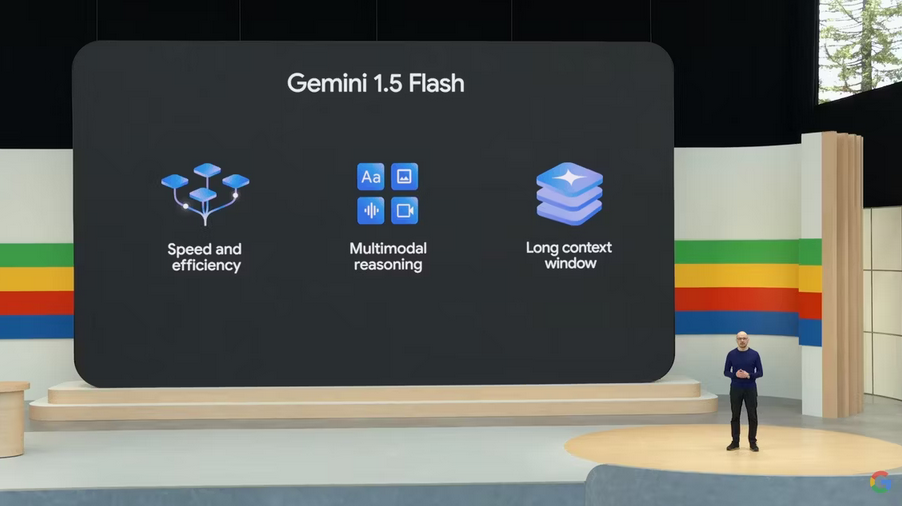

Google ha appena fatto un altro importante passo avanti nella sua era Gemini, lanciando Gemini 1.5 Flash al Google I/O di quest’anno. È un modello Gemini più piccolo, rivolto a compiti più ristretti o ad alta frequenza, incentrato sulla velocità di risposta piuttosto che sulla qualità e sulla conoscenza approfondita delle risposte. È ora disponibile in oltre 200 paesi in anteprima e raggiungerà la disponibilità generale a giugno.

Gemini 1.5 Flash si colloca tra 1.5 Pro e 1.5 Nano, ma Google afferma che è potente quanto la variante Pro. Una delle caratteristiche più straordinarie di Gemini 1.5 Flash è la sua capacità di ragionamento multimodale. Può elaborare e ragionare su diversi tipi di informazioni, inclusi testo, immagini e video, il che lo rende versatile per molteplici tipi di attività.

Ci sono alcune differenze notevoli tra Gemini 1.5 Flash e Gemini 1.5 Pro. Il primo è destinato a coloro che hanno a cuore la velocità di uscita, mentre il secondo ha più peso e funziona in modo simile al grande modello 1.0 Ultra di Google. Josh Woodward, vicepresidente di Google Labs di Google, sottolinea che gli sviluppatori dovrebbero utilizzare Gemini 1.5 Flash se stanno cercando di affrontare attività rapide in cui è importante la bassa latenza. D’altra parte, spiega, Gemini 1.5 Pro è orientato verso “attività di ragionamento più generali o complesse, spesso in più fasi“.

Gli sviluppatori ora hanno una più ampia scelta di IA tra cui scegliere rispetto a un approccio unico per tutti. Non tutte le app richiedono gli stessi dati e funzionalità di intelligenza artificiale e la presenza di variazioni può fare la differenza nel modo in cui gli utenti sperimentano un servizio basato sull’intelligenza artificiale. Ciò che può essere interessante è che Google ha trovato un modo per offrire agli sviluppatori un modello di intelligenza artificiale all’avanguardia, accelerandone al tempo stesso le prestazioni. Forse lo svantaggio più grande è che non è addestrato su set di dati sufficientemente grandi da soddisfare gli sviluppatori. In tal caso, l’opzione successiva è passare a Gemini 1.5 Pro.

Gemini 1.5 Flash ha una finestra di contesto di 1M di token

Ancora più interessante è che Gemini 1.5 Flash, proprio come altri modelli della famiglia Gemini, presenta la finestra contestuale estremamente lunga di Google, in grado di gestire fino a 1 milione di token. La “distillazione” è il processo utilizzato da Google per trasferire le conoscenze e le competenze più essenziali dal modello 1.5 Pro più grande al modello Flash più piccolo.

Gemini 1.5 Flash sarà disponibile per l’utilizzo da parte di più persone in futuro, anche se non è ancora noto quali software e servizi includerà. Sembra essere un valido concorrente del GPT-4o di OpenAI (insieme al Google Project Astra), supponendo che possa rispondere più velocemente o dare risposte migliori, ma resta da vedere.

La finestra di contesto di Google è la novità più importante in questo caso, poiché 1 milione di token per un LLM multimodale gli consente di comprendere un’enorme quantità di dati di testo, immagini, audio o video contemporaneamente, qualcosa che può essere estremamente utile per molti persone.

Google pubblicherà un rapporto tecnico per Gemini 1.5 Flash, ma per ora puoi controllare come si comporta nei benchmark.