Al giorno d’oggi ogni grande azienda tecnologica vuole la sua fetta della torta dell’intelligenza artificiale. Google ha Gemini, OpenAI ha ChatGPT e Samsung ha il suo Galaxy AI, ma questa è solo la punta dell’iceberg. Microsoft è stata tra le prime sulla scena dell’intelligenza artificiale generativa, fornendo fondi vitali agli sforzi di OpenAI. E ora sta iniziando a raccogliere i frutti della sua lungimiranza. Dopo aver lanciato la sua app Android Copilot basata su ChatGPT, l’azienda ha svelato Phi-3 Mini, un modello di intelligenza artificiale molto più piccolo che potrebbe trovare casa anche sugli smartphone.

L’obiettivo è fornire un’alternativa più economica agli LLM basati sul cloud, consentendo alle organizzazioni più piccole di adottare l’intelligenza artificiale.

Le capacità di Microsoft Phi-3 Mini

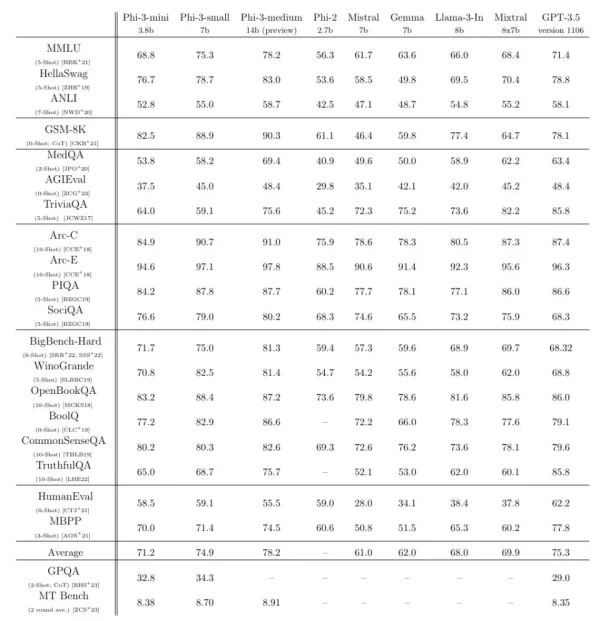

Secondo Microsoft, il nuovo modello supera di gran lunga il suo precedente modello piccolo Phi-2 ed è alla pari con modelli più grandi come Llama 2. Infatti, l’azienda afferma che Phi-3 Mini fornisce risposte vicine al livello di un modello 10 volte più grande come GPT-3.5.

Dal punto di vista tecnico, quest’ultimo modello presenta 3,8 miliardi di parametri ed è attualmente disponibile su Ollama, Hugging Face e Azure. L’azienda prevede di rilasciare ulteriori modelli in questa serie chiamati Phi-3 Small (7 miliardi di parametri) e Phi-3 Medium (14 miliardi di parametri), con il compromesso che più parametri significano istruzioni più complesse, mentre meno significano una migliore portabilità. Attualmente, GPT-4 ha oltre un trilione di parametri e il modello Llama 3 su piccola scala di Meta ne arriva a 8 miliardi.

“L’innovazione risiede interamente nel nostro set di dati per la formazione“, secondo il documento di ricerca. Questo set di dati si basa sul modello Phi-2, ma utilizza “dati web fortemente filtrati e dati sintetici”, afferma il team. In effetti, per svolgere entrambe queste attività è stato utilizzato un LLM separato, creando di fatto nuovi dati che consentono al modello linguistico più piccolo di essere più efficiente.

Secondo Eric Boyd, vicepresidente della piattaforma AI di Microsoft Azure, Phi-3 Mini è efficiente quanto modelli come GPT-3.5, “solo in un fattore di forma più piccolo”. Essendo un modello AI compatto, dovrebbe essere più economico e offrire anche prestazioni migliori su dispositivi come laptop e telefoni. Per migliorare le sue prestazioni, un secondo LLM è stato usato per creare un libro per bambini di 3.000 parole da integrare nel set di dati dell’addestramento di Phi-3 Mini. Ciò ha permesso di utilizzare un linguaggio più semplice per affrontare argomenti complessi.

La sfida sugli LLM piccoli è sempre più accesa

Se la sfida per gli LLM più complessi e capaci è accesa, la stessa cosa si può dire per quelli di piccole dimensioni. Abbiamo appena visto Microsoft lanciare il suo Phi-3 Mini e Meta il suo Llama 3 ma anche Google è nella partita con i suoi modelli Gemma.