L’alba dell’era degli smartphone nel 2008 e l’ascesa dei social media hanno reso indispensabile avere una buona fotocamera per tutti coloro che vogliono stare al passo. Ma prima che le fotocamere degli smartphone iniziassero a scattare la maggior parte delle foto del mondo, queste venivano scattate con dispositivi molto più grandi di quasi tutti i dispositivi mobili che li hanno sostituiti.

Com’è possibile? Cosa sta succedendo all’interno del nostro telefono che gli consente di scattare foto da 200 MP?

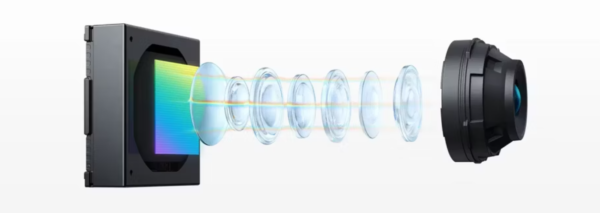

Tutte le fotocamere degli smartphone sono composte da tre parti fondamentali. Il primo è l’obiettivo che dirige la luce nella fotocamera. Il secondo è il sensore che converte i fotoni di luce focalizzati in un segnale elettrico. E il terzo è il software che converte quei segnali elettrici in una foto pronta per Instagram. Diamo un’occhiata più da vicino a ciascuna di queste parti.

Obiettivo

Prima che la luce raggiunga il sensore di immagine, deve passare attraverso l’obiettivo. E prima ancora, passa attraverso un piccolo foro nel corpo del telefono. La dimensione di quel foro è chiamata apertura e determina quanta luce entra nel sensore della fotocamera.

In generale, un’apertura più ampia è una buona cosa per le fotocamere mobili perché significa che la fotocamera ha più luce con cui lavorare.

Una volta che la luce entra nel modulo della fotocamera, l’obiettivo raccoglie la luce in arrivo dallo scatto e la dirige verso il sensore. Le fotocamere degli smartphone sono costituite da molte lenti in plastica chiamate elementi. A causa della natura della luce, diverse lunghezze d’onda della luce (colori) vengono rifratte (piegate) ad angoli diversi mentre passano attraverso una lente. Ciò significa che i colori della scena vengono proiettati sul sensore della fotocamera fuori allineamento.

Per allineare nuovamente i fotoni è necessario un sistema di messa a fuoco. La maggior parte degli smartphone affida al software la messa a fuoco, anche se in alcuni casi vi è dell’hardware aggiuntivo come un telemetro laser o una combinazione dei due.

Sensore

Il sensore è un sottile wafer di silicio. Il suo unico compito è trasformare i fotoni (luce) in elettroni (segnali elettrici). Questa conversione fotovoltaica avviene in milioni di fotositi sulla minuscola superficie del sensore.

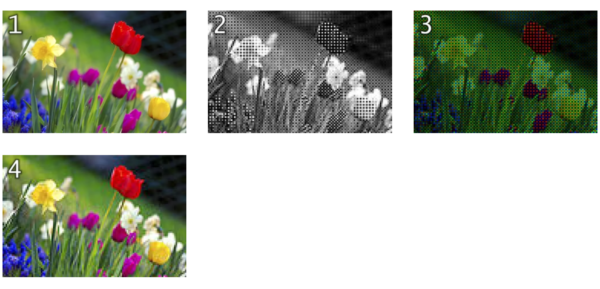

Se nessun fotone raggiunge il photosite, il sensore registra quel pixel come nero. Se molti fotoni raggiungono il photosite, quel pixel è bianco. Il numero di sfumature di grigio che il sensore può registrare è noto come profondità di bit.

Quindi, come fa il tuo telefono a scattare foto a colori? Sopra ogni photosite è sovrapposto un filtro colorato che lascia passare solo determinati colori di luce. L’array di filtri colorati Bayer è il più comune e divide ogni quadrato 2 × 2 di fotositi in un filtro rosso, uno blu e due verdi (RGGB).

I sensori SuperSpectrum di Huawei sono una notevole eccezione ai tradizionali CFA RGGB. Huawei utilizza filtri gialli (RYYB) anziché filtri verdi per consentire il passaggio di più luce, migliorando i dati di luminanza.

Questo mosaico di dati di colore e luce deve essere convertito in un’immagine a colori tramite complicati algoritmi di demosaicizzazione.

Le due metriche del sensore a cui prestare attenzione sono la sua dimensione e la dimensione dei suoi pixel. Le dimensioni del sensore sono misurate in frazioni di pollice: in generale, un sensore più grande (come il sensore da 1/1,31 pollici di Google Pixel 7 Pro) produce immagini migliori perché ha fotositi sempre più grandi.

I fotositi (il cui numero costituisce il numero potenziale di megapixel della fotocamera) sono misurati in micrometri (µm). I fotositi più grandi sono in grado di raccogliere meglio la luce, rendendoli ideali per condizioni di scarsa illuminazione. I photosite più piccoli non significano necessariamente foto di qualità inferiore. Tuttavia, è una metrica che potresti prendere in considerazione se prevedi di utilizzare la fotocamera del telefono in condizioni di scarsa illuminazione.

Una tecnica per compensare i piccoli photosite (è l’unico modo per avere oltre 100 MP su un sensore) è il pixel binning. Ciò significa combinare 4, 8 o addirittura 16 pixel insieme per incamerare tutte le loro informazioni raccolte sulla luce in un unico super pixel.

Software di elaborazione

Una volta che il sensore di immagine ha svolto il suo lavoro e ha convertito la luce portata dagli obiettivi in un segnale elettrico, è compito dell’ISP (Image Signal Processor) trasformare quegli 1 e 0 in un’immagine degna di Snapchat.

I dati inviati all’ISP sono essenzialmente un’immagine in bianco e nero (un’immagine RAW per gli appassionati là fuori). Il primo compito dell’ISP è riportare i dati di colore basati sulla disposizione nota del CFA. Ora abbiamo un’immagine, ma i suoi pixel hanno intensità variabili di rosso, verde o blu (o rosso, giallo e blu per i telefoni Huawei).

Il passo successivo è un processo chiamato demosaicizzazione. È qui che l’ISP modifica i colori dei pixel in base ai colori dei suoi vicini. Se, ad esempio, in un’area sono presenti molti pixel verdi e rossi ma poco blu, l’algoritmo di demosaicizzazione li converte in giallo.

Finalmente abbiamo una foto! La maggior parte degli ISP applica denoising e sharpening dopo la demosaicizzazione. Tuttavia, ogni OEM ha la propria pipeline e algoritmi per produrre un’immagine finale. Google, in particolare, è noto per l’utilizzo di algoritmi sviluppati dall’intelligenza artificiale per produrre alcune delle migliori foto per smartphone.